История создания искусственного интеллекта. Кто придумал ИИ?

Обновлено: 10.10.2024 |

Машина Тьюринга

Можно считать, что история искусственного интеллекта начинается с вопроса "Может ли логика человеческого мышления быть механизирована?", автором которого называют математика Рене Декарта, жившего в 17 веке.

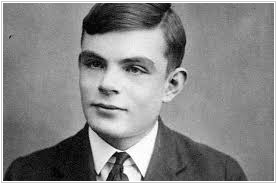

Ответом на этот вопрос считается Машина Тьюринга (разработанная Аланом Тьюрингом в 1936 году) - абстрактная модель механического устройства, которая (теоретически) может автоматически решить любую логическую задачу.

Алан Тьюринг

Появление компьютеров

Первыми не-абстрактными логическими устройствами - компьютерами - были огромные вычислительные машины для взлома шифров времен Второй мировой войны (такие как Z3, ENIAC и Colossus). Последние две были основаны на теории Алана Тьюринга и архитектуре Джона фон Неймана.

Джон фон Нейман

Модель нейрона и нейросети

Открытия в неврологии 40-х годов показали, что мозг - это электрическая сеть из нейронов, и это вызвало всплеск идей в кибернетике. В 1943 году в своей статье «Логическое исчисление идей, относящихся к нервной активности» Уоррен Маккалок и Уолтер Питтс предложили понятие искусственной нейронной сети. В частности, ими была предложена модель искусственного нейрона.

Уоррен Маккалок и Уолтер Питтс

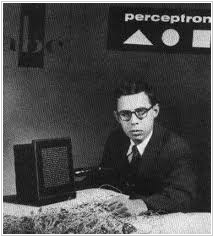

Несколько лет спустя американский нейрофизиолог Фрэнк Розенблатт создал первую математическую модель работы и обучения нейросети с обратным распространением ошибки - "Перцептрон".

Фрэнк Розенблатт

Имитация интеллекта

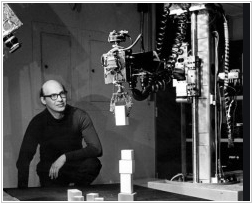

В 1950 году Алан Тьюринг придумал "Тест Тьюринга", который сформулировал цель создания думающей машины. В 50-х годах исследователи пытались строить разумные машины, имитирующие человеческий мозг и интеллект. Первую вычислительную машину на основе нейросети (SNARC) построил в 1951 году Марвин Минский.

Марвин Минский

В 1956 г. состоялась Дартмутская конференция, где Джон Маккарти, профессор Стэнфорда, впервые предложил термин "Искусственный интеллект" (Artificial Intelligence).

Джон Маккарти

В 1966 профессор MIT Джозеф Вейценбаум создал чат-бота ELIZA, которая претендовала на прохождение теста Тьюринга - могла правдоподобно поддерживать беседу.

Джозеф Вейценбаум

60-е годы называют Золотым веком ИИ. Обещания ученых создать полноценный интеллект в течении 10 лет и имитации интеллекта (типа Элизы) привлекли большие инвестиции от DAPRA и других государственных агентств.

Зима искусственного интеллекта

Однако, имитация интеллекта не позволила решать практические задачи. Попытка масштабировать нейросети на аппаратном обеспечении того времени оказалась слишком трудным и бесплодным делом. Поэтому, в 70-е годы финансирование ИИ-проектов было остановлено. Этот период называют Зимой ИИ.

В конце концов сам же Марвин Минский раскритиковал модель Перцептрона (Фрэнка Розенблатта), чем на 10 лет заморозил развитие нейросетей. А сам же Джозеф Вейценбаум раскритиковал идею доверить искусственному интеллекту решение человеческих задач (из-за отсутствия у него человеческих знаний).

Экспертные системы

Неразрешимые проблемы с нейросетями привели к зарождению альтернативного подхода к созданию интеллекта - на основе логики связей между знаниями. Идея была в том, чтоб с помощью базы знаний и набора правил запрограммировать компьютер на решение узкоспециализированных задач. В начале 80-х появились первые Экспертные системы, работающие на этой технологии. Например, медицинская экспертная система MYCIN по ряду ответов на вопросы ставила диагноз. Крестным отцом экспертных систем называют американского ученого Эдварда Фейгенбаума.

Эдвард Фейгенбаум

Экспертные системы действительно работали и, поначалу, привлекли значительное финансирование. Но они требовали специализированного аппаратного обеспечения, участия экспертов и инженеров. Их создание и модификация обходились очень дорого. Поэтому, в конце 80-х это направление ИИ тоже было свернуто.

Машинное обучение

В конце 80-х начала развиваться область машинного обучения нейросетей. Машинное обучение позволило создавать интеллектуальные системы без знаний эксперта, а лишь с помощью набора обучающих примеров. Канадский ученый Джеффри Хинтон адаптировал технологию обратного распространения ошибки для глубоких нейросетей.

Джеффри Хинтон

В 1989 году французский профессор Ян Лекун создал первую систему компьютерного зрения на базе сверточной нейросети.

Ян Лекун

Благодаря технологии машинного обучения в 90-х годах нейронные сети получили коммерческое применение в областях распознавания текста (OCR) и речи.

Суперкомпьютеры и Deep Learning

В 2000-х годах мощности компьютеров стремительно росли. Появились суперкомпьютеры, наиболее известным из которых стал IBM Watson (выигравший у людей в интеллектуальном шоу Jeopardy!).

Появилась возможность обучать глубокие нейросети (с большим числом слоев). Наибольший вклад в совершенствование технологий глубокого обучения внес профессор Монреальского университета Йошуа Бенжио. Его вместе с Яном Лекуном и Джеффри Хинтоном называют крестными отцами Искусственного интеллекта.

Йошуа Бенжио

Облачные вычисления и Big Data

В 2010-х годах, благодаря появлению облачных платформ (Cloud Computing), компьютерные мощности стали не только дешевыми, но и общедоступными. Компании и люди, использующие эти платформы, начали генерировать огромные объемы данных (Big Data), которые служили пищей для систем глубокого обучения.

Для просчета нейросетей вместо компьютеров на фон-Неймановской архитектуре начали использовать видеокарты (GPU) с большим количеством маленьких процессоров, что еще больше ускорило их обучение и работу.

Наконец-то ИИ системы стали коммерчески успешными и востребованными практически в любом бизнесе. ИТ гиганты: IBM, Google, Microsoft, Amazon, Facebook - сделали Искусственный интеллект важным направлением своей стратегии и внедрили ИИ в свои основные продукты (виртуальные ассистенты, онлайн переводчики, поиск, системы бизнес-аналитики и безопасности, самоуправляемые авто...).

Появилось множество ИИ стартапов, привлекших десятки миллиардов инвестиций (Deepmind, Siri, Waymo, WorkFusion, SoundHound...).

Демис Хассабис

Основатель наиболее успешного стартапа Deepmind Демис Хассабис создал модель ИИ на базе технологии обучения с подкреплением (reinforcement learning), которая быстро научилась играть в шахматы, Го и компьютерные игры лучше человека.

Языковые модели и GPT

В 2017 году разработчики Google опубликовали статью "Attention Is All You Need", которая описывала технологию Transformer, упрощающую создание нейросетей для обработки естественного языка.

Стартап OpenAI, основанный Сэмом Альтманом, использовал эту технологию для создания модели GPT (Generative Pre-trained Transformer), которая умела обучаться на любых текстах и генерировать язык. В 2022 компания открыла доступ к чат-боту ChatGPT, который мог общаться и правдоподобно отвечать на любой вопрос на основе всех знаний из интернета (с запасом прошел тест Тьюринга).

Сэм Альтман

Можно считать, что история искусственного интеллекта начинается с вопроса "Может ли логика человеческого мышления быть механизирована?", автором которого называют математика Рене Декарта, жившего в 17 веке.

Ответом на этот вопрос считается Машина Тьюринга (разработанная Аланом Тьюрингом в 1936 году) - абстрактная модель механического устройства, которая (теоретически) может автоматически решить любую логическую задачу.

Алан Тьюринг

Появление компьютеров

Первыми не-абстрактными логическими устройствами - компьютерами - были огромные вычислительные машины для взлома шифров времен Второй мировой войны (такие как Z3, ENIAC и Colossus). Последние две были основаны на теории Алана Тьюринга и архитектуре Джона фон Неймана.

Джон фон Нейман

Модель нейрона и нейросети

Открытия в неврологии 40-х годов показали, что мозг - это электрическая сеть из нейронов, и это вызвало всплеск идей в кибернетике. В 1943 году в своей статье «Логическое исчисление идей, относящихся к нервной активности» Уоррен Маккалок и Уолтер Питтс предложили понятие искусственной нейронной сети. В частности, ими была предложена модель искусственного нейрона.

Уоррен Маккалок и Уолтер Питтс

Несколько лет спустя американский нейрофизиолог Фрэнк Розенблатт создал первую математическую модель работы и обучения нейросети с обратным распространением ошибки - "Перцептрон".

Фрэнк Розенблатт

Имитация интеллекта

В 1950 году Алан Тьюринг придумал "Тест Тьюринга", который сформулировал цель создания думающей машины. В 50-х годах исследователи пытались строить разумные машины, имитирующие человеческий мозг и интеллект. Первую вычислительную машину на основе нейросети (SNARC) построил в 1951 году Марвин Минский.

Марвин Минский

В 1956 г. состоялась Дартмутская конференция, где Джон Маккарти, профессор Стэнфорда, впервые предложил термин "Искусственный интеллект" (Artificial Intelligence).

Джон Маккарти

В 1966 профессор MIT Джозеф Вейценбаум создал чат-бота ELIZA, которая претендовала на прохождение теста Тьюринга - могла правдоподобно поддерживать беседу.

Джозеф Вейценбаум

60-е годы называют Золотым веком ИИ. Обещания ученых создать полноценный интеллект в течении 10 лет и имитации интеллекта (типа Элизы) привлекли большие инвестиции от DAPRA и других государственных агентств.

Зима искусственного интеллекта

Однако, имитация интеллекта не позволила решать практические задачи. Попытка масштабировать нейросети на аппаратном обеспечении того времени оказалась слишком трудным и бесплодным делом. Поэтому, в 70-е годы финансирование ИИ-проектов было остановлено. Этот период называют Зимой ИИ.

В конце концов сам же Марвин Минский раскритиковал модель Перцептрона (Фрэнка Розенблатта), чем на 10 лет заморозил развитие нейросетей. А сам же Джозеф Вейценбаум раскритиковал идею доверить искусственному интеллекту решение человеческих задач (из-за отсутствия у него человеческих знаний).

Экспертные системы

Неразрешимые проблемы с нейросетями привели к зарождению альтернативного подхода к созданию интеллекта - на основе логики связей между знаниями. Идея была в том, чтоб с помощью базы знаний и набора правил запрограммировать компьютер на решение узкоспециализированных задач. В начале 80-х появились первые Экспертные системы, работающие на этой технологии. Например, медицинская экспертная система MYCIN по ряду ответов на вопросы ставила диагноз. Крестным отцом экспертных систем называют американского ученого Эдварда Фейгенбаума.

Эдвард Фейгенбаум

Экспертные системы действительно работали и, поначалу, привлекли значительное финансирование. Но они требовали специализированного аппаратного обеспечения, участия экспертов и инженеров. Их создание и модификация обходились очень дорого. Поэтому, в конце 80-х это направление ИИ тоже было свернуто.

Машинное обучение

В конце 80-х начала развиваться область машинного обучения нейросетей. Машинное обучение позволило создавать интеллектуальные системы без знаний эксперта, а лишь с помощью набора обучающих примеров. Канадский ученый Джеффри Хинтон адаптировал технологию обратного распространения ошибки для глубоких нейросетей.

Джеффри Хинтон

В 1989 году французский профессор Ян Лекун создал первую систему компьютерного зрения на базе сверточной нейросети.

Ян Лекун

Благодаря технологии машинного обучения в 90-х годах нейронные сети получили коммерческое применение в областях распознавания текста (OCR) и речи.

Суперкомпьютеры и Deep Learning

В 2000-х годах мощности компьютеров стремительно росли. Появились суперкомпьютеры, наиболее известным из которых стал IBM Watson (выигравший у людей в интеллектуальном шоу Jeopardy!).

Появилась возможность обучать глубокие нейросети (с большим числом слоев). Наибольший вклад в совершенствование технологий глубокого обучения внес профессор Монреальского университета Йошуа Бенжио. Его вместе с Яном Лекуном и Джеффри Хинтоном называют крестными отцами Искусственного интеллекта.

Йошуа Бенжио

Облачные вычисления и Big Data

В 2010-х годах, благодаря появлению облачных платформ (Cloud Computing), компьютерные мощности стали не только дешевыми, но и общедоступными. Компании и люди, использующие эти платформы, начали генерировать огромные объемы данных (Big Data), которые служили пищей для систем глубокого обучения.

Для просчета нейросетей вместо компьютеров на фон-Неймановской архитектуре начали использовать видеокарты (GPU) с большим количеством маленьких процессоров, что еще больше ускорило их обучение и работу.

Наконец-то ИИ системы стали коммерчески успешными и востребованными практически в любом бизнесе. ИТ гиганты: IBM, Google, Microsoft, Amazon, Facebook - сделали Искусственный интеллект важным направлением своей стратегии и внедрили ИИ в свои основные продукты (виртуальные ассистенты, онлайн переводчики, поиск, системы бизнес-аналитики и безопасности, самоуправляемые авто...).

Появилось множество ИИ стартапов, привлекших десятки миллиардов инвестиций (Deepmind, Siri, Waymo, WorkFusion, SoundHound...).

Демис Хассабис

Основатель наиболее успешного стартапа Deepmind Демис Хассабис создал модель ИИ на базе технологии обучения с подкреплением (reinforcement learning), которая быстро научилась играть в шахматы, Го и компьютерные игры лучше человека.

Языковые модели и GPT

В 2017 году разработчики Google опубликовали статью "Attention Is All You Need", которая описывала технологию Transformer, упрощающую создание нейросетей для обработки естественного языка.

Стартап OpenAI, основанный Сэмом Альтманом, использовал эту технологию для создания модели GPT (Generative Pre-trained Transformer), которая умела обучаться на любых текстах и генерировать язык. В 2022 компания открыла доступ к чат-боту ChatGPT, который мог общаться и правдоподобно отвечать на любой вопрос на основе всех знаний из интернета (с запасом прошел тест Тьюринга).

Сэм Альтман